In un articolo precedente, abbiamo esplorato il Retrieval-Augmented Generation (RAG) locale utilizzando LM Studio e AnythingLLM. Oggi, ci addentriamo in un altro potente strumento per il RAG locale: GPT4All.

Il RAG, in termini semplici, è una tecnica che migliora i modelli di IA recuperando informazioni rilevanti da una base di conoscenza prima di generare risposte. È come dare alla tua IA una biblioteca personalizzata da consultare durante le conversazioni.

GPT4All porta questa capacità sul tuo desktop, permettendoti di eseguire modelli linguistici di grandi dimensioni localmente e privatamente mentre sfrutti i tuoi stessi documenti come fonte di conoscenza. Esploriamo come GPT4All renda il RAG locale accessibile ed efficiente sia per gli utenti quotidiani che per gli sviluppatori.

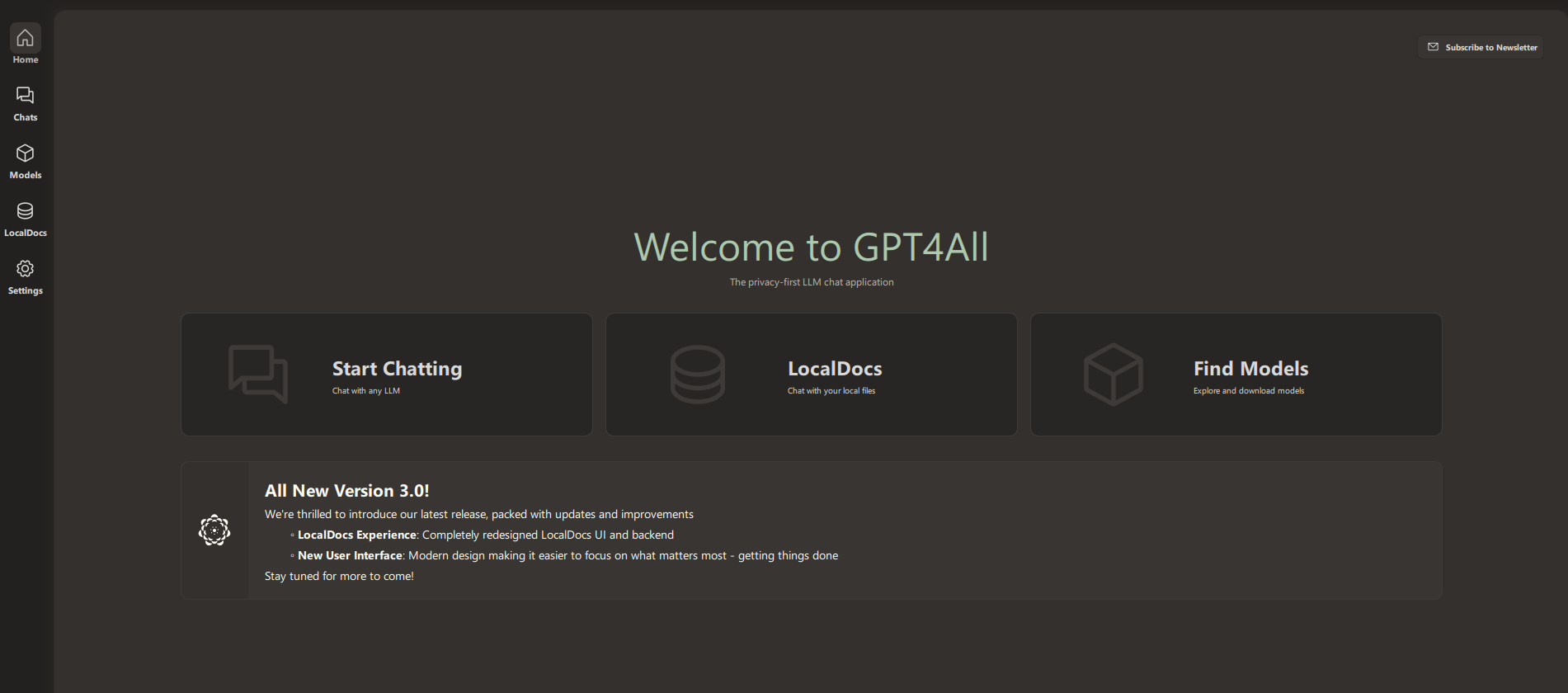

Applicazione Desktop GPT4All: LLM in Locale

GPT4All è più di una semplice interfaccia di chat IA. È un’applicazione desktop completa progettata per portare la potenza dei modelli linguistici di grandi dimensioni (LLM) direttamente sul tuo dispositivo. Ecco cosa rende GPT4All eccezionale:

- Elaborazione Locale: A differenza dei servizi IA basati su cloud, GPT4All funziona interamente sulla tua macchina. Questo significa tempi di risposta più rapidi e, crucialmente, una privacy migliorata per i tuoi dati.

- Flessibilità dei Modelli: L’applicazione ti permette di scaricare e passare tra vari LLM. Che tu preferisca Llama 3 o voglia sperimentare con altri modelli, GPT4All ti copre.

- Funzione LocalDocs: È qui che GPT4All brilla veramente per gli entusiasti del RAG. LocalDocs ti permette di trasformare i tuoi file personali in una base di conoscenza per l’IA, abilitando conversazioni contestuali basate sui tuoi stessi dati.

- Supporto Multi-Piattaforma: Che tu sia su Windows, Mac o Linux, GPT4All ha una versione per te, garantendo accessibilità su diversi sistemi operativi.

- Interfaccia User-Friendly: Nonostante le sue potenti funzionalità, GPT4All mantiene un’interfaccia pulita e intuitiva che rende le interazioni IA accessibili sia ai principianti che agli esperti.

Iniziare con GPT4All

Iniziare con GPT4All è semplice:

- Scarica e installa l’applicazione per il tuo sistema operativo dal sito web ufficiale di GPT4All.

- Avvia l’app e clicca su “Inizia a chattare”.

- Aggiungi un modello cliccando su “+ Aggiungi Modello”. Per i principianti, Llama 3 è un buon punto di partenza.

- Una volta scaricato il tuo modello, naviga nella sezione Chat e carica il modello scelto.

- Ora sei pronto per iniziare a interagire con la tua IA locale! Nella prossima sezione, approfondiremo la configurazione e l’uso di LocalDocs, la funzione che porta le capacità RAG al tuo assistente IA personale.

LocalDocs: Chatta con i Tuoi Documenti Localmente

Sbloccare LocalDocs: La Tua Base di Conoscenza IA Personale

LocalDocs è l’implementazione di RAG di GPT4All, che ti permette di migliorare le tue interazioni IA con informazioni dai tuoi file personali. Ecco come funziona e come configurarlo:

Comprendere LocalDocs:

LocalDocs utilizza un processo di embedding per creare un indice ricercabile dei tuoi documenti. Quando chatti con l’IA, può quindi recuperare informazioni rilevanti da questo indice per informare le sue risposte. Questo significa che la tua IA può “leggere” e fare riferimento ai tuoi documenti, mantenendo i tuoi dati completamente locali e privati.

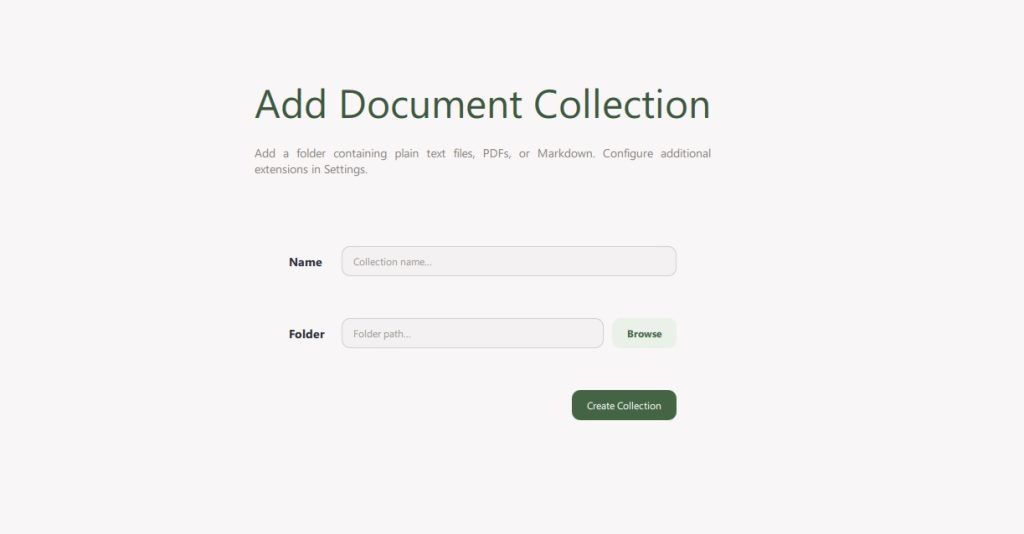

Configurare LocalDocs:

- Nell’interfaccia di GPT4All, trova e clicca sul pulsante “+ Aggiungi Collezione”.

- Dai un nome alla tua collezione e collegala a una cartella contenente i documenti che vuoi includere. Questa potrebbe essere una cartella di documenti di lavoro, articoli di ricerca, o qualsiasi file basato su testo che vuoi che l’IA consulti.

- Clicca su “Crea Collezione“. Vedrai una barra di avanzamento mentre GPT4All elabora i tuoi documenti.

- Una volta completato, vedrai un indicatore verde “Pronto”. Non preoccuparti se hai una grande collezione – puoi iniziare a usare LocalDocs con i file che sono pronti mentre il resto continua l’elaborazione.

- Per usare LocalDocs nelle tue chat, cerca il pulsante LocalDocs nell’angolo in alto a destra dell’interfaccia di chat. Questo attiva l’uso della tua base di conoscenza locale.

- Durante la chat, puoi visualizzare le fonti delle informazioni dell’IA cliccando su “Fonti” sotto le sue risposte.

Embeddings:

LocalDocs utilizza i modelli di embedding di Nomic AI per creare rappresentazioni vettoriali dei tuoi frammenti di testo. Questi vettori catturano il significato semantico del testo, permettendo al sistema di trovare informazioni rilevanti basate sulla similarità tra la tua query e il testo incorporato.

Quando fai una domanda, GPT4All:

- Incorpora la tua query in un vettore.

- Cerca vettori simili nella tua collezione LocalDocs.

- Recupera i frammenti di testo più rilevanti.

- Include questi frammenti nel prompt inviato al LLM.

- Genera una risposta basata sia sul suo addestramento che sulle informazioni locali recuperate.

Questo processo avviene in modo fluido e rapido, fornendoti risposte IA basate sulla tua base di conoscenza personale.

Suggerimenti per un Uso Efficace di LocalDocs:

- Organizza i tuoi documenti in collezioni a tema per un recupero più mirato.

- Aggiorna regolarmente le tue collezioni per mantenere aggiornata la conoscenza dell’AI.

- Sperimenta con diversi tipi di documenti per vedere cosa funziona meglio per le tue esigenze.

Requisiti Hardware per Local RAG:

GPT4All è progettato per funzionare in modo efficiente su PC moderni, ma avere l’hardware giusto garantisce prestazioni ottimali. Per un funzionamento fluido, mira ad avere almeno 16GB di RAM e un processore che supporti le istruzioni AVX2.

Una GPU dedicata con 8GB+ di VRAM può migliorare significativamente le prestazioni, soprattutto per modelli più grandi e collezioni estese di LocalDocs.

Per gli utenti Windows e Linux, qualsiasi CPU moderna con supporto AVX2 è sufficiente, mentre gli utenti macOS necessitano di un chip Apple Silicon M1 o successivo con macOS 13.6+.

Nella prossima sezione, esploreremo alcune applicazioni pratiche di GPT4All con LocalDocs, mostrando come questa potente combinazione possa migliorare la tua produttività e il processo decisionale.

Casi d'Uso per Local RAG:

Applicazioni Pratiche: GPT4All e LocalDocs in Azione

La combinazione delle capacità LLM locali di GPT4All e della funzionalità RAG di LocalDocs apre un mondo di possibilità sia per uso personale che professionale. Ecco alcune applicazioni pratiche:

Gestione della Personal Knowledge

- Sommario di Documenti: Ottieni rapidamente riassunti di documenti lunghi o articoli di ricerca nella tua collezione.

- Aiuto allo Studio: Crea una collezione LocalDocs con i tuoi materiali di studio e usa GPT4All per fare quiz o spiegare concetti complessi.

- Analisi del Diario Personale: Ottieni intuizioni dai tuoi scritti personali creando una collezione dai tuoi diari.

Ricerca Professionale

- Revisione della Letteratura: Crea una collezione di articoli accademici e usa GPT4All per trovare connessioni o riassumere i punti chiave tra più fonti.

- Analisi dei Brevetti: Crea una collezione di documenti di brevetto e usa l’AI per identificare tendenze o potenziali violazioni.

Business Intelligence

- Ricerca di Mercato: Analizza una collezione di articoli di notizie, rapporti e documenti interni per estrarre tendenze di mercato e intelligence competitiva.

- Analisi del Feedback dei Clienti: Processa grandi volumi di feedback dei clienti e usa GPT4All per identificare problemi comuni o sentimenti.

Legale e Compliance

- Analisi dei Contratti: Crea una collezione di documenti legali e usa GPT4All per trovare rapidamente clausole rilevanti o potenziali problemi.

- Conformità delle Politiche: Crea una collezione di politiche aziendali e regolamenti, quindi usa l’AI per verificare se nuovi documenti o proposte sono conformi alle regole esistenti.

Sviluppo Software

- Documentazione del Codice: Usa LocalDocs per indicizzare il tuo codice e la documentazione del progetto, quindi usa GPT4All per generare spiegazioni o trovare frammenti di codice rilevanti.

- Analisi dei Bug: Crea una collezione di report sui bug e usa l’AI per identificare modelli o suggerire soluzioni potenziali.

Creazione Contenuti

- Assistenza alla Scrittura: Crea una collezione dei tuoi scritti precedenti o guide di stile, quindi usa GPT4All per mantenere un tono e uno stile coerente nei nuovi pezzi.

- Verifica dei Fatti: Usa una collezione curata di fonti affidabili per verificare le informazioni nei tuoi contenuti.

Finanza Personale

- Ricerca di Investimenti: Crea una collezione di rapporti finanziari e usa GPT4All per analizzare le opportunità di investimento o riassumere le performance aziendali.

- Analisi del Budget: Indicizza i tuoi documenti finanziari personali e usa l’AI per tracciare i modelli di spesa o suggerire ottimizzazioni del budget.

Esempio di Workflow: Ricerca di Mercato con GPT4All e LocalDocs

- Crea una collezione LocalDocs con rapporti di settore, analisi dei concorrenti e dati di mercato interni.

- Chiedi a GPT4All: “Quali sono le tendenze emergenti nel nostro settore basate sui documenti nella mia collezione?”

- Segui con: “Come si allineano le strategie dei nostri concorrenti con queste tendenze?”

- Usa le intuizioni dell’AI, supportate dai tuoi documenti, per informare la tua strategia di mercato.

Il vantaggio principale dell’uso di GPT4All con LocalDocs per queste applicazioni è la combinazione delle capacità AI con la tua base di conoscenza privata e curata.

Questo assicura che le risposte dell’AI siano non solo intelligenti ma anche altamente rilevanti e personalizzate al tuo contesto e alle tue esigenze specifiche.

Leggi anche: Python per la SEO: crea un tool di analisi dei contenuti